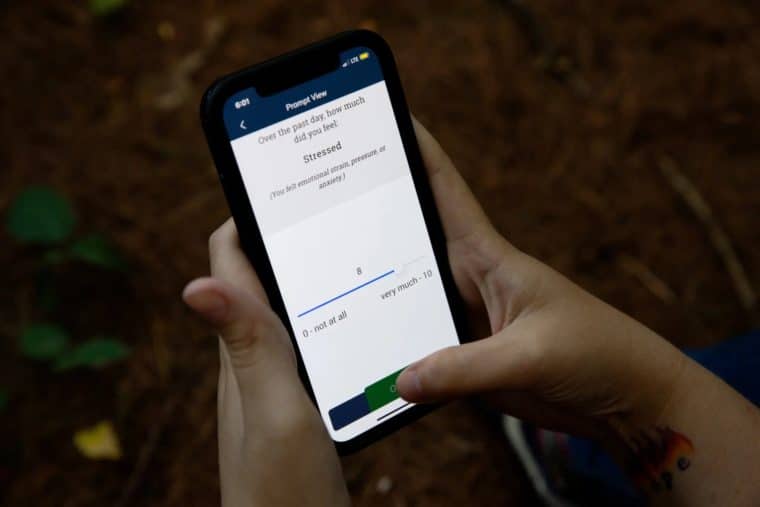

- Un proyecto de investigación exclusivo está rastreando a cientos de personas, en riesgo de cometer suicidio, utilizando datos de teléfonos inteligentes y biosensores portátiles para identificar periodos de alto peligro y así poder intervenir. Foto: Kayana Szymczak para The New York Times

Esta es una traducción hecha por El Diario de la nota Can Smartphones Help Predict Suicide?, original de The New Yort Times.

En marzo, Katelin Cruz salió de su última hospitalización psiquiátrica con una mezcla de sentimientos encontrados. Por una parte, se sintió aliviada de salir de la sala, donde los ayudantes le quitaron los cordones de los zapatos y, en ocasiones, la siguieron hasta la ducha para asegurarse de que no se hiciera daño.

Pero su vida en el exterior era tan inestable como siempre -según dijo en una entrevista- con un montón de facturas sin pagar y sin un hogar permanente. Era fácil volver a caer en pensamientos suicidas. Para los pacientes vulnerables, las semanas posteriores al alta de un centro psiquiátrico son un periodo notoriamente difícil, con una tasa de suicidios casi 15 veces mayor a la tasa nacional, según un estudio.

Esta vez, sin embargo, Cruz, de 29 años de edad, dejó el hospital como parte de un vasto proyecto de investigación que intenta utilizar los avances en inteligencia artificial para hacer algo que han eludido los psiquiatras durante siglos: predecir quién probablemente intente suicidarse y cuándo lo intente; para luego intervenir y detenerlo.

En su muñeca, llevaba un Fitbit programado para rastrear su sueño y actividad física. En su smartphone, una aplicación recopilaba datos sobre su estado de ánimo, sus movimientos y sus interacciones sociales. Cada dispositivo proporcionaba un flujo continuo de información a un equipo de investigadores en el piso 12 del edificio William James, que alberga el departamento de psicología de Harvard.

En el campo de la salud mental, pocas áreas nuevas generan tanto entusiasmo como el aprendizaje automático, que utiliza algoritmos informáticos para predecir mejor el comportamiento humano. Al mismo tiempo, existe un gran interés en los biosensores que pueden rastrear el estado de ánimo de una persona en tiempo real, teniendo en cuenta las elecciones de música, las publicaciones en las redes sociales, la expresión facial y la expresión vocal.

Matthew K. Nock, un psicólogo de Harvard que es uno de los principales investigadores del suicidio en Estados Unidos, espera unir estas tecnologías en una especie de sistema de alerta temprana que podría usarse cuando un paciente en riesgo es dado de alta del hospital.

Él ofrece este ejemplo de cómo podría funcionar: el sensor notifica que el sueño de un paciente está perturbado, informa un bajo estado de ánimo en los cuestionarios y el GPS muestra que no sale de la casa. Pero un acelerómetro en su teléfono revela que se mueve mucho, lo que sugiere agitación. El algoritmo marca al paciente. Suena un ping en un tablero. Y, en el momento justo, un médico se comunica a través de una llamada telefónica o por un mensaje.

Hay muchas razones para dudar de que un algoritmo pueda alcanzar este nivel de precisión. El suicidio es un evento tan extraño, incluso entre las personas con mayor riesgo, que cualquier esfuerzo por predecirlo dará como resultado falsos positivos, lo que obligará a intervenir a personas que tal vez no las necesiten. Los falsos negativos podrían suponer una responsabilidad legal para los médicos.

Los algoritmos requieren datos granulares a largo plazo de un gran número de personas, y es casi imposible observar a un gran número de personas que mueran por cometer suicidio. Finalmente, los datos necesarios para este tipo de monitoreo generan señales de alerta sobre la invasión de la privacidad de algunas de las personas más vulnerables de la sociedad.

El doctor Nock está familiarizado con todos estos argumentos, pero ha sido persistente, en parte por pura frustración. “Con el debido respeto a las personas que han estado haciendo este trabajo durante décadas, durante un siglo, no hemos aprendido mucho sobre cómo identificar a las personas en riesgo y cómo intervenir”, dijo. “La tasa de suicidios ahora es la misma que era literalmente hace 100 años. Entonces, si somos honestos, no estamos mejorando”.

La zona gris

Para los psiquiatras, pocas tareas son más estresantes que cuidar a los pacientes que están en riesgo de suicidio mientras están en casa y sin supervisión.

La doctora Karen L. Swartz, profesora de psiquiatría en la Universidad Johns Hopkins, lo llama “la zona gris”. Acababa de terminar su entrenamiento cuando luchó por primera vez con este problema, cuidando a una mujer inteligente e irritante que admitió que tenía pensamientos suicidas e incluso hizo alusión a un plan, pero temía ser hospitalizada.

Swartz buscó al esposo de la mujer para obtener un consejo. Pero este le respondió: si la obligas a entrar en el hospital, te despedirá.

Entonces, la doctora Swartz decidió correr el riesgo y permitió que la mujer se quedara en casa, ajustando sus medicamentos y esperando por resultados. Pasó las siguientes semanas en ascuas y, lentamente, la paciente mejoró. “Fue una de esas cosas en las que realmente esperaba tener razón”, dijo. Nunca es fácil, confesó Swartz, quien ahora capacita a jóvenes psiquiatras: a través de la experiencia, solo se vuelve más claro que los pensamientos suicidas pueden aparecer y desaparecer sin previo aviso.

“Se nos pide que predigamos algo que es altamente impredecible”, comentó.

A medida que pasa el tiempo, los sistemas de atención médica recurren al aprendizaje automático para hacer esta llamada. Se utilizan algoritmos basados en grandes conjuntos de datos, extraídos de registros médicos electrónicos, así como de puntajes de otros factores, para asignar a los pacientes un puntaje de riesgo. De esta forma las personas con un riesgo excepcionalmente alto pueden recibir atención adicional.

Los algoritmos han demostrado ser más precisos que los métodos tradicionales, pues -según una revisión de 2017 de investigaciones publicadas– estos últimos no habían mejorado en 50 años y solo eran un poco mejores que la probabilidad de predecir un resultado. Lo métodos con algoritmos ya se utilizan en algunos entornos clínicos. Desde 2017, el Departamento de Asuntos de Veteranos ha utilizado un algoritmo para señalar al 0,1 % de los veteranos con mayor riesgo de suicidio, lo que representa unos pocos miles de pacientes en una población de seis millones.

Este enfoque ha tenido cierto éxito. Un estudio publicado el año pasado en JAMA Network Open encontró que los veteranos inscritos en REACH VET, un programa para pacientes en riesgo, tenían un 5 % menos de probabilidades de sufrir un intento de suicidio documentado y menos probabilidades de ser admitidos en un centro psiquiátrico o visitar la sala de emergencias. Pero el estudio no encontró cambios significativos en la tasa de suicidio.

Las expectativas que se han creado en torno a esta investigación son tan altas que los expertos se esfuerzan por moderarlas. Michael Schoenbaum, asesor principal del Instituto Nacional de Salud Mental, lo comparó con el entusiasmo de hace 25 años sobre la búsqueda de marcadores biológicos para las enfermedades mentales, un caso en el que, señaló, “los optimistas estaban equivocados”.

Y algunos de los colegas de Nock dicen que dudan que las predicciones algorítmicas sean lo suficientemente precisas para intervenir en esa estrecha ventana que precede a un intento de suicidio.

“Ciertamente no es un problema de fácil solución”, dijo Nick Allen, director del Centro de Salud Mental Digital de la Universidad de Oregón, quien ayudó a desarrollar EARS, una aplicación que rastrea el estado de ánimo en función de factores como la elección de música, la expresión facial y el uso del lenguaje.

“Probablemente, en algunos sentidos, no sea un problema solucionable, por la misma razón por la que tenemos tiroteos en las escuelas y por la misma razón por la que no podemos predecir muchas de estas cosas”, dijo Allen. “Las matemáticas son realmente desalentadoras”.

Una manguera contra el incendios de datos

Durante una tarde de agosto en el edificio William James, un alargado científico de datos llamado Adam Bear se sentó frente a un monitor en el laboratorio del doctor Nock, usando chanclas y pantalones cortos holgados, mirando los gráficos en zigzag de los niveles de estrés de un hombre durante el transcurso de una semana.

Cuando los estados de ánimo se mapean como datos, surgen patrones y el trabajo de Adam Bear es buscarlos. Pasó su verano estudiando detenidamente los días y las horas de 571 personas quienes, después de buscar atención médica por pensamientos suicidas, aceptaron ser monitoreados continuamente durante seis meses. Mientras estaban siendo rastreados, dos se suicidaron y entre 50 y 100 lo intentaron.

Se trata, según cree el doctor Nock, de la mayor reserva de información jamás recopilada sobre la vida cotidiana de las personas que luchan contra los pensamientos suicidas.

El equipo está más interesado en los días previos a los intentos de suicidio, lo que daría tiempo para intervenir y evitarlo. Ya han surgido algunos síntomas: aunque los impulsos suicidas a menudo no cambian en el periodo anterior a un intento, la capacidad de resistir esos impulsos parece disminuir. Un elemento simple, la privación del sueño parece contribuir a eso.

El doctor Nock ha estado buscando formas de estudiar a estos pacientes desde 1994, cuando tuvo una experiencia que lo conmocionó profundamente. Durante una pasantía de pregrado en el Reino Unido, lo asignaron a una unidad cerrada para pacientes violentos y autolesivos. Allí vio cosas que nunca había visto: los pacientes tenían cortes en los brazos. Uno de ellos se sacó su propio globo ocular. Un joven del que se hizo amigo y que parecía estar mejorando, fue encontrado sin vida más tarde en el Támesis.

Se llevó otra sorpresa cuando comenzó a bombardear a los médicos con preguntas sobre el tratamiento de estos pacientes y se dio cuenta de lo poco que sabían: recuerda que le dijeron: “Les damos un medicamento, hablamos con ellos y esperamos que se mejoren”.

Una de las razones, concluyó, era que nunca había sido posible estudiar a un gran número de personas con ideas suicidas de la misma manera que podemos observar a los pacientes con enfermedades cardíacas o tuberculosis. “La psicología no ha avanzado tanto como otras ciencias porque en gran medida lo hemos estado haciendo mal”, dijo. “No hemos salido y encontrado algún comportamiento que sea determinante, y luego ido a estudiarlo”.

Pero con la llegada de las aplicaciones para teléfonos y los sensores portátiles, agregó, “tenemos datos de tantos canales diferentes y, cada vez más, tenemos la capacidad de analizar esos datos y observar a las personas mientras viven sus vidas”. Un dilema en el diseño del estudio fue qué hacer cuando los participantes expresaron un fuerte deseo de hacerse daño. Nock decidió que los médicos debían intervenir.

“Hay una desventaja en esto porque hay menos intentos y menos suicidios porque, científicamente, ahora estamos disminuyendo la probabilidad de encontrar una señal”, indicó. Pero, agregó, “sigo volviendo al tema de, ¿y si fuera mi hijo?”.

Las intervenciones se han convertido en una parte rutinaria de la vida en el laboratorio. Si en un cuestionario de rutina un paciente informa sobre un fuerte deseo de autolesionarse, y es entre las 9 am y las 9 pm, recibirá una llamada dentro de los 15 minutos siguientes por parte de uno de los investigadores, quien le pregunta si se ha intentado lastimar.

“Somos una especie de personas sin rostro, por lo que hay menos incomodidad”, detalló Narise Ramlal, asistente de investigación en el laboratorio. Sin embargo, el doctor Nock se pregunta, y espera probar que así sea, si las intervenciones digitales pueden resultar más efectivas.

“Muchas personas no quieren que un humano se comunique con ellas cuando son de alto riesgo”, dijo. “Esto no quiere decir que vamos a reemplazar a los humanos con máquinas, pero probablemente puedan ser mucho más eficientes de lo que somos ahora”.

Diciéndole la verdad a una computadora

Eran alrededor de las 9 pm, unas pocas semanas después del estudio de seis meses, cuando apareció la pregunta en el teléfono de Katherin Cruz: “¿En este momento, qué tan fuerte es tu deseo de suicidarte?”.

Sin detenerse a pensar, arrastró su dedo hasta el final de la barra y marcó el número 10. Unos segundos después, se le pidió que eligiera entre dos afirmaciones: “No me voy a suicidar hoy” y “Me voy a suicidar hoy”. Marcó la segunda.

15 minutos después, sonó su teléfono. Era una integrante del equipo de investigación quien la llamó. Luego, esa misma mujer llamó al 911 y mantuvo a Katherin Cruz en la línea hasta que la policía llegó a su puerta y, cuando eso ocurrió, Cruz se desmayó. Más tarde, cuando recuperó el conocimiento, un equipo médico le estaba frotando el esternón, un procedimiento doloroso que se usa para revivir a las personas después de una sobredosis.

Cruz tiene un rostro pálido y seráfico, y una franja de rizos oscuros. Ella había estado estudiando para obtener un título en enfermería cuando una serie de crisis de salud mental hicieron que su vida se desviara en una dirección diferente. Ella mantiene el interés nerd de un estudiante sobresaliente en ciencias, y bromea diciendo que la caja torácica en su camiseta es “anatómicamente correcta”.

De inmediato, comenzó el interrogatorio y respondió obedientemente, seis veces al día, cuando las aplicaciones en su teléfono la encuestaron sobre sus pensamientos suicidas. Los pings eran invasivos, pero también reconfortantes. “Sentí que no estaba siendo ignorada”, dijo. “Tener a alguien que sepa cómo me siento, me quita algo de peso de encima”.

La noche que intentó suicidarse, estaba sola en una habitación de hotel en Concord. No tenía suficiente dinero para pasar otra noche allí y sus pertenencias estaban amontonadas en bolsas de basura en el suelo. Estaba cansada, dijo, “de sentir que no tenía a nadie ni nada”. Mirando hacia el pasado, Katherin dijo que la tecnología, la privacidad que esta le brindaba y la ausencia de alguien que la juzgara, hicieron que fuera más fácil pedir ayuda.

“Creo que es casi más fácil decirle la verdad a una computadora”, dijo.

Pero muchos especialistas en el área desconfían en la idea de que la tecnología pueda sustituir la atención de un médico. Una de las razones es que los pacientes en crisis se vuelven expertos en el engaño, comentó Justin Melnick, de 24 años de edad, estudiante de doctorado quien sobrevivió a un intento de suicidio en 2019 y ahora es defensor de las personas con enfermedades mentales.

Recordó tener breves conversaciones telefónicas con su madre, la persona más capaz de sacarlo del “precipicio”, y luego apagar el teléfono. “Y fue como, OK, esa puerta se ha cerrado”, dijo. Describió esas evasiones como “un acto de desafío”. ¿Por qué, preguntó, una persona en ese estado de ánimo estaría de acuerdo en usar un sensor?

Al final, dijo, lo que lo ayudó a dar la vuelta fue un grupo de apoyo, que se reunía semanalmente en un círculo de sillas para sesiones de terapia conductual dialéctica, y una red de amigos, familiares y médicos que lo conocen lo suficientemente bien como para reconocer su comportamiento. Cuando eso sucede, indicó, “generalmente podemos montarnos en esa ola juntos” y superarlo.

Katherin Cruz, sin embargo, no tiene una red de apoyo como esa. El mes antepasado, cuando las temperaturas en Massachusetts descendieron a los 40 grados, ella vivía en una tienda de campaña con su novio, acurrucados bajo una manta para calentarse. Por la mañana, esperaron a que abriera McDonald’s para poder secar sus sudaderas y zapatos y cargar sus dispositivos.

Siguió al pie de la letra las instrucciones sobre tomar sus cinco medicamentos, pero estaba luchando por encontrar a un nuevo terapeuta: el único en su área que acepta Medicaid tiene una lista de espera de ocho meses.

La semana pasada, cuando el ensayo clínico de seis meses llegó a su fin, llenó su cuestionario final con un dejo de tristeza. Echaría de menos ese dólar que recibía por cada respuesta. Y extrañaría la sensación de que alguien la observaba, aunque fuera alguien sin rostro, a distancia, a través de un dispositivo.

“Honestamente, me hace sentir un poco más segura saber que alguien se preocupa lo suficiente como para leer esos datos todos los días, ¿sabes?”, dijo ella. “Estaré un poco triste cuando el estudio termine”.

Traducido por José Silva