- Delincuentes recrearon un video en el que el jugador hacía supuestas peticiones de transacciones bancarias. Foto: EFE

El acelerado avance de la inteligencia artificial (IA) ha hecho que diversas empresas alerten a los usuarios sobre los sofisticados métodos de estafas en línea que emplean delincuentes para obtener dinero. En uno de ellos fue utilizado el nombre del futbolista Cristiano Ronaldo.

Reportes de medios internacionales, el martes 5 de marzo, refieren que la imagen y voz del jugador portugués fue utilizada sin su autorización para cometer diversos delitos, por lo que allegados al futbolista pidieron ignorar cualquier solicitud relacionada con dinero.

El jugador del Al-Nassr, de Arabia Saudita, aparece en un video presuntamente creado con herramientas de IA en el que el propio jugador supuestamente pedía datos sensibles como tarjetas de crédito y claves para pagar supuestos fondos escolares para sus hijos, detalló un reporte de la agencia Reuters.

Las señales que alertaron a los usuarios

El video, que ha sido removido de diversas plataformas, generó dudas entre los usuarios quienes indicaron que a pesar de la similitud de la voz del jugador con la imagen recreada, aseguraron que existían imprecisiones en el audio, además de notar como algo “muy extraño” que el jugador hiciera ese tipo de peticiones a sus seguidores.

Empresas de tecnología como la rusa Kaspersky y la estadounidense Cisco Systems han resaltado la importancia de educar a la comunidad sobre los riesgos persistentes ante el crecimiento de este tipo de herramientas.

De acuerdo con especialistas en seguridad informática consultados por El Diario, una de las características principales de supuestas solicitudes de dinero a través de audios, es el “tono de urgencia” con que se realizan las peticiones.

“Normalmente lo hacen para generar preocupaciones en la posible víctima y así apurar la transacción bancaria para luego ser bloqueadas”, explicó Daniel Vargas, especialista en ciberseguridad.

Otras víctimas de la inteligencia artificial

La recreación de voces a través de la IA ha ocasionado diversas demandas de figuras públicas, quienes han denunciado el uso indebido de sus voces e imágenes.

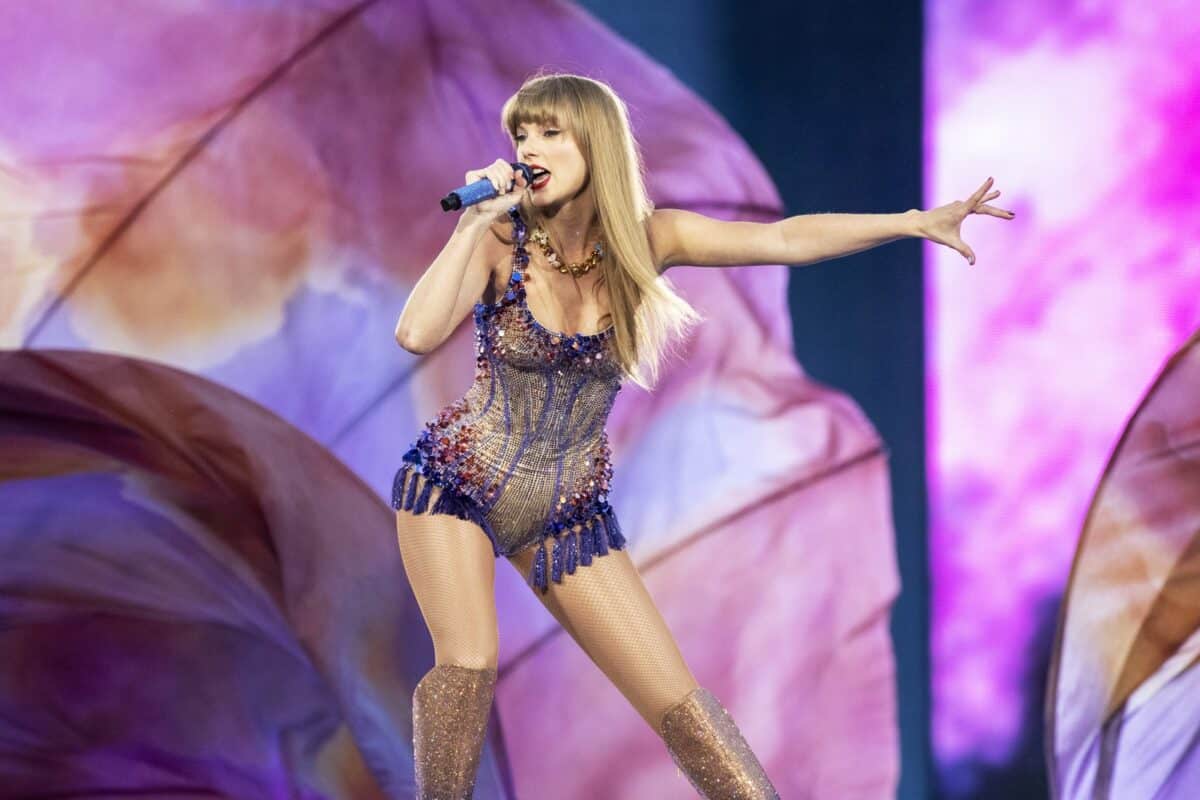

Uno de los casos más recientes fue el de la cantante estadounidense Taylor Swift luego de la difusión de unas fotos en las que crearon imágenes sexuales de la intérprete hechas a través de programas de IA.

Miles de seguidores de la artista expresaron su indignación al respecto, por lo que las fotos fueron bloqueadas en la plataforma X (antes Twitter) donde se habían difundido en su mayoría.

Una de esas imágenes difundidas en X atrajo 45 millones de visitas al perfil de esta red social y contó con 24 mil retuits y miles de “me gusta”, según un reporte del sitio web tecnológico Xataka el 29 de enero de 2024.

¿Cómo protegerse de delitos asociados con IA?

Detectar imágenes y voces falsas creadas con inteligencia artificial puede convertirse en un desafío, según expertos. Sin embargo, existen algunas técnicas y herramientas que pueden ayudar a identificar la manipulación.

Algunas estrategias para detectarlas son:

-Revisar detalles inusuales: inspeccionar cuidadosamente la imagen o la grabación de voz en busca de detalles que resulten inconsistentes. Estos podrían incluir artefactos visuales extraños, distorsiones en la voz o discontinuidades en la apariencia de las personas o los objetos.

-Comparar con fuentes confiables: en caso de sospechas de que una imagen o una grabación de voz podría ser falsa, se sugiere compararla con otras fuentes confiables. Buscar imágenes o grabaciones similares de fuentes verificadas para ver si hay diferencias significativas.

-Evaluación del contexto: tener en cuenta el contexto en el que se presenta la imagen o la grabación de voz. Si la información parece demasiado buena para ser verdad o si se utiliza para respaldar una narrativa falsa, es posible que debas ser más escéptico y realizar una verificación más exhaustiva.

-Acudir a expertos: si existen dudas sobre la autenticidad de una imagen o una grabación de voz, se recomienda consultar a especialistas en análisis o verificación de contenidos. Varios de ellos poseen herramientas necesarias para evaluar la autenticidad del archivo.