- Meta detalló en un reciente estudio que en las pruebas realizadas con LIMA esta arrojó respuestas competitivas a las del GPT-4

En los últimos meses varias compañías de tecnología han mostrado sus avances en cuanto al desarrollo de herramientas con inteligencia artificial (IA). De acuerdo con el portal Xataka, aunque OpenAI parece llevar la delantera con el GPT-4, las alternativas han avanzado; así lo demuestran el modelo PaLM 2 de Google y ahora una variante del modelo LLaMa de Meta, denominado LIMA.

En un reciente estudio, Meta explicó que los grandes modelos de lenguaje se entrenan en dos fases. En la primera se realiza un entrenamiento previo sin supervisión de texto sin procesar, que permite aprender en un escenario de propósito general; mientras que en la segunda se realiza una instrucción a gran escala donde se aplica un aprendizaje por refuerzo para alinear el modelo a ciertas tareas o preferencias del usuario.

Durante el desarrollo de esos entrenamientos es que se crea Less Is More for Alingment (LIMA, por sus siglas en inglés). “Medimos la importancia relativa de estas dos etapas entrenando LIMA, un modelo del lenguaje LLaMa”, indicó la compañía.

¿Qué es LIMA y cómo funciona?

LIMA es un modelo de lenguaje basado en LLaMa con 65 millones de parámetros. Esta herramienta se ha afinado con tan solo 1.000 prompts y respuestas especialmente preparadas para que se comporte de la forma adecuada.

En el estudio Meta destacó que no ha sido necesario un refuerzo de aprendizaje por refuerzo o modelado de preferencias humanas, y aún así su comportamiento ha sido sobresaliente.

“LIMA demuestra una notable solidez de desempeño, aprendiendo a seguir formatos de respuesta específicos de solo un puñado de ejemplos en los datos de entrenamiento, incluidas consultas complejas que van desde la planificación de itinerarios de viaje hasta especular sobre la historia alternativa”, detalló.

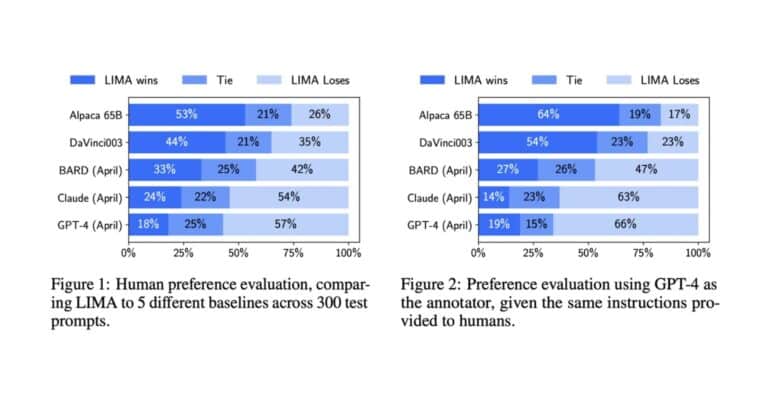

Además, el modelo tiende a generalizar bien las tareas no vistas que no aparecían en los datos de entrenamiento. En un estudio humano controlado, las respuestas de LIMA son equivalentes a GPT-4 en el 43 % de los casos.

En este sentido, Meta sostuvo que tomados en conjunto, esos resultados sugieren que casi todo el conocimiento de los grandes modelos de lenguaje se aprenden durante el preentrenamiento y que solo se necesitan datos de ajuste de instrucciones limitados para enseñar a los modelos a producir resultados de alta calidad.

Desarrollo del modelo

El modelo LIMA lo desarrolló Meta en colaboración con la Universidad Carnegie Mellon, la Universidad del Sur de California y la Universidad de Tel Aviv. Así se puede visualizar en el estudio.

De acuerdo con Xataka, una de las conclusiones importantes de la investigación es que el uso de la técnica Reinforcement Learning from Human Feedback (RLHF) no aporta tantas mejoras como se creía.

En ese sistema una serie de usuarios humanos recompensan al modelo para optimizar su comportamiento a medida que lo van entrenando. El RLHF es un proceso caro que utilizan en OpenAI para afinar sus modelos y que usan en GPT-4 para mejorar las prestaciones del modelo.

Meta aseguró que eso plantea la hipótesis en la que la llamada fase de alineamiento tras el entrenamiento inicial se debe centrar en enseñar al modelo un cierto formato o estilo al que pueda acudir en la interacción con los usuarios.

El equipo de investigadores de LIMA precisó que construir los conjuntos de datos con ejemplos de alta calidad es todo un reto y no siempre es una opción escalable. Aún con los buenos resultados del estudio, LIMA sigue estando por debajo de GPT-4. Esto debido a que, aunque genera buenas respuestas, un mal ejemplo en su afinado podría llevar a ofrecer respuestas poco precisas.