- La compañía matriz de Facebook señaló que la tecnología puede hacer relaciones entre imágenes, sonidos y movimientos para la generación de contenidos

La empresa Meta presentó su nueva herramienta de inteligencia artificial (IA) que emula los sentidos humanos. Este proceso lo realiza a través de la relación entre siete fuentes de datos sensoriales: imágenes, video, audio, texto, profundidad, temperatura y movimiento.

La compañía matriz de Facebook, Instagram y WhatsApp informó que la nueva tecnología se llama ImageBind y es capaz de analizar información de diferentes recursos de forma simultánea.

Meta define este proceso como un “entendimiento holístico” y asegura que es similar a las capacidades del ser humano. La empresa agregó que la tecnología podría incluir nuevas modalidades de datos sensoriales como el tacto, el olor, el discurso y las imágenes por resonancia magnética.

“Cuando los humanos absorben información del mundo, usamos múltiples sentidos de manera innata, como ver una calle concurrida y escuchar los sonidos de los motores de los automóviles. Hoy presentamos un enfoque que lleva a las máquinas un paso más cerca de la capacidad de los humanos para aprender de forma simultánea, holística y directa de muchas formas diferentes de información”, indicó Meta en el comunicado.

Algunas de sus funciones

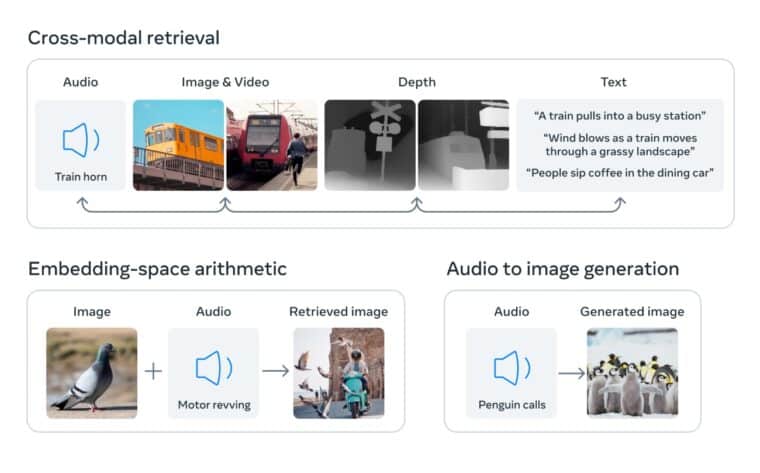

La empresa detalló que entre las tareas que se podrían realizar con ImageBind está la posibilidad de conectar elementos de una fotografía con su sonido, su forma en tres dimensiones o su movimiento.

Otra función sería la de generar imágenes a partir de sonidos introducidos en la herramienta de IA.

De acuerdo con Meta, ImageBind se utilizará en conjunto con el metaverso, un proyecto de la compañía que busca crear mundos virtuales y experiencias inmersivas. La empresa agregó que la IA será un gran apoyo en el campo este campo de investigación a medida que avancen las herramientas tecnológicas.

El proceso de segmentación que realiza ImageBind permitiría, por ejemplo, tomar varios elementos de una foto y crear animaciones para cada uno. Además, podría seleccionar el sonido adecuado para el producto final.

“Un creador podría combinar una imagen con un despertador y el canto de un gallo, y usar un mensaje de audio de canto para segmentar el gallo o el sonido de una alarma para segmentar el reloj y animar ambos en una secuencia de video”, señala el comunicado de Meta.

La empresa espera que la herramienta se pueda seguir entrenando para funciones que se acerquen más al entendimiento humano. Asimismo alentó a los investigadores a evaluar y trabajar con esta IA para el desarrollo de nuevos estudios.